نوبل هوش مصنوعی یا نوبل فیزیک؟

برندگان امسال جایزه نوبل فیزیک از ابزارهای فیزیک برای ایجاد روشهایی استفاده کردند که پایه و اساس یادگیری ماشینی قدرتمند امروزی را فراهم کرد. جان هاپفیلد ساختاری ایجاد کرد که قادر به ذخیره و بازسازی اطلاعات است. جفری هینتون روشی اختراع کرد که میتواند بهصورت مستقل ویژگیهای دادهها را کشف کند؛ روشی که اکنون برای شبکههای عصبی مصنوعی بزرگ مورد استفاده قرار میگیرد.

آنها از فیزیک برای کشف الگوها در اطلاعات استفاده کردند

بسیاری از مردم تجربه کردهاند که کامپیوترها میتوانند بین زبانها ترجمه کنند، تصاویر را تفسیر کنند و حتی مکالمات منطقی داشته باشند. شاید کمتر شناخته شده باشد که این نوع فناوری مدتهاست در پژوهشها، بهویژه در مرتبسازی و تحلیل حجم عظیمی از دادهها، اهمیت زیادی دارد. توسعه یادگیری ماشینی طی پانزده تا بیست سال گذشته با سرعت بالایی پیشرفت کرده است و از ساختاری به نام شبکه عصبی مصنوعی استفاده میکند. امروزه، وقتی از هوش مصنوعی صحبت میکنیم، اغلب منظورمان این نوع فناوری است.

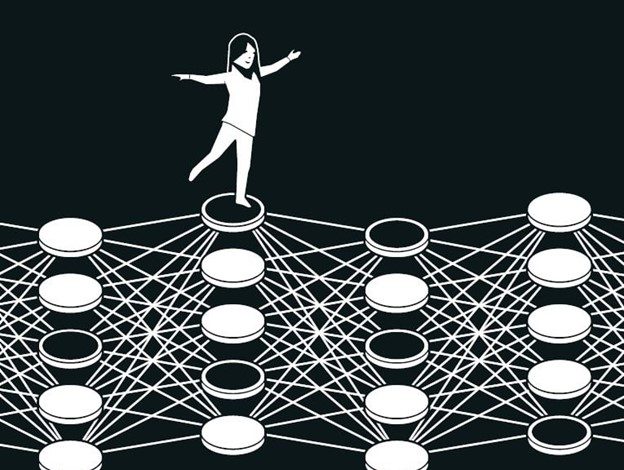

اگرچه کامپیوترها قادر به فکر کردن نیستند، اما ماشینها اکنون میتوانند برخی از عملکردهای حافظه و یادگیری را تقلید کنند. برندگان امسال جایزه نوبل فیزیک به تحقق این امر کمک کردهاند. آنها با استفاده از مفاهیم و روشهای بنیادی فیزیک، فناوریهایی توسعه دادهاند که از ساختارهای موجود در شبکهها برای پردازش اطلاعات استفاده میکنند.

یادگیری ماشینی با نرمافزارهای سنتی تفاوت دارد. نرمافزارهای سنتی مانند یک دستورالعمل آشپزی عمل میکنند؛ دادهها را دریافت کرده، طبق دستور مشخصی آنها را پردازش میکنند و سپس نتیجهای مشابه پختن یک کیک با پیروی از دستور تهیه، ارائه میدهند. اما در یادگیری ماشینی، کامپیوتر با مثالها یاد میگیرد و این امکان را پیدا میکند که با مشکلاتی که بسیار پیچیده و مبهم هستند و نمیتوانند با دستورالعملهای گامبهگام حل شوند، مقابله کند. برای مثال، تفسیر یک تصویر برای شناسایی اشیای موجود در آن.

تقلید از مغز

یک شبکه عصبی مصنوعی اطلاعات را با استفاده از کل ساختار شبکه پردازش میکند. الهام اولیه از تمایل به درک چگونگی عملکرد مغز ناشی شد. در دهه ۱۹۴۰، محققان شروع به بررسی ریاضیات زیرساختی شبکه نورونها و سیناپسهای مغز کردند. یکی دیگر از اجزای این پازل از روانشناسی و از فرضیه عصبشناس، دونالد هب، درباره نحوه یادگیری به دست آمد. او بیان کرد که وقتی نورونها با هم کار میکنند، ارتباطات میان آنها تقویت میشود و یادگیری به این صورت رخ میدهد.

بعدها، تلاشهایی صورت گرفت تا عملکرد شبکه مغزی با ساخت شبکههای عصبی مصنوعی به صورت شبیهسازی رایانهای بازسازی شود. در این شبکهها، نورونهای مغز توسط گرههایی که مقادیر متفاوتی دارند، شبیهسازی میشوند و سیناپسها توسط اتصالات بین این گرهها که میتوانند قویتر یا ضعیفتر شوند، نمایش داده میشوند. فرضیه دونالد هب همچنان بهعنوان یکی از قوانین پایه برای بهروزرسانی شبکههای مصنوعی از طریق فرآیندی به نام آموزش استفاده میشود.

در اواخر دهه ۱۹۶۰، نتایج نظری دلسردکنندهای باعث شد بسیاری از محققان به این نتیجه برسند که شبکههای عصبی هیچگاه کاربرد واقعی نخواهند داشت. اما در دهه ۱۹۸۰، علاقه به شبکههای عصبی مصنوعی دوباره زنده شد، زمانی که چندین ایده مهم، از جمله کار برندگان امسال، تاثیرگذار شد.

حافظه تداعیگر

تصور کنید که میخواهید یک کلمه نسبتاً نادر را به خاطر بیاورید که به ندرت از آن استفاده میکنید؛ مثلاً کلمهای برای کف شیبداری که معمولاً در سینماها و سالنهای سخنرانی وجود دارد. در ذهن خود جستجو میکنید. چیزی شبیه به شیب است… شاید شیر… نه، این هم نه. شوش، بله، همین است!

این فرآیند جستجو میان کلمات مشابه برای پیدا کردن کلمه درست، شبیه به حافظه تداعیگری است که فیزیکدان جان هاپفیلد در سال ۱۹۸۲ کشف کرد. شبکه هاپفیلد میتواند الگوهایی را ذخیره کند و روشی برای بازسازی آنها داشته باشد. وقتی به این شبکه یک الگوی ناقص یا کمی تحریفشده داده میشود، این روش میتواند الگوی ذخیرهشدهای را که بیشترین شباهت را دارد، پیدا کند.

هاپفیلد پیش از این با استفاده از پیشزمینه خود در فیزیک، مسائل نظری در زیستشناسی مولکولی را بررسی کرده بود. وقتی به یک نشست درباره علوم اعصاب دعوت شد، با تحقیقاتی درباره ساختار مغز مواجه شد. او مجذوب آنچه آموخته بود شد و شروع به اندیشیدن درباره پویایی شبکههای عصبی ساده کرد. وقتی نورونها با هم عمل میکنند، میتوانند ویژگیهای جدید و قدرتمندی ایجاد کنند که برای کسی که فقط به اجزای جداگانه شبکه نگاه میکند، آشکار نیست.

در سال ۱۹۸۰، هاپفیلد از سمت خود در دانشگاه پرینستون که تحقیقاتش او را به خارج از زمینههای فیزیک سوق داده بود، کنارهگیری کرد و به سمت دیگری در آن سوی قاره نقل مکان کرد. او پیشنهاد استادی در رشته شیمی و زیستشناسی در مؤسسه فناوری کالیفرنیا (Caltech) در پاسادنا، جنوب کالیفرنیا را پذیرفت. در آنجا، او به منابع رایانهای دسترسی داشت که میتوانست برای انجام آزمایشهای آزادانه و توسعه ایدههای خود درباره شبکههای عصبی از آنها استفاده کند.

با این حال، او از پایههای فیزیکی خود دست نکشید؛ جایی که الهاماتی برای درک او از چگونگی شکلگیری پدیدههای جدید و جالب توسط سیستمهایی با اجزای کوچک و متعدد که با هم کار میکنند، یافت. او به ویژه از آموختههای خود درباره مواد مغناطیسی بهره برد که به لطف چرخش اتمی (اسپین) ویژگیهای خاصی دارند – خاصیتی که باعث میشود هر اتم مانند یک آهنربای کوچک عمل کند. اسپینهای اتمهای همسایه بر یکدیگر تأثیر میگذارند و این امکان را فراهم میکنند که حوزههایی با اسپین در یک جهت شکل بگیرند. هاپفیلد توانست با استفاده از فیزیکی که توصیف میکند چگونه مواد در اثر تأثیر متقابل اسپینها شکل میگیرند، شبکهای با گرهها و اتصالات مدلسازی کند.

شبکه تصاویر را در یک منظره ذخیره میکند

شبکهای که هاپفیلد ساخت، شامل گرههایی است که همگی از طریق اتصالاتی با قدرتهای مختلف به هم متصل شدهاند. هر گره میتواند یک مقدار مستقل ذخیره کند – در اولین کار هاپفیلد، این مقدار میتوانست ۰ یا ۱ باشد، مشابه پیکسلها در یک تصویر سیاه و سفید.

هاپفیلد حالت کلی شبکه را با خاصیتی توصیف کرد که معادل انرژی در سیستم اسپینهای فیزیکی است؛ این انرژی با استفاده از فرمولی محاسبه میشود که تمام مقادیر گرهها و تمام قدرتهای اتصالات بین آنها را در نظر میگیرد. شبکه هاپفیلد از طریق ورود یک تصویر به گرهها برنامهریزی میشود، بهطوری که هر گره مقدار سیاه (۰) یا سفید (۱) میگیرد. سپس اتصالات شبکه با استفاده از فرمول انرژی تنظیم میشوند تا تصویری که ذخیره شده است انرژی کمی داشته باشد. وقتی الگوی دیگری به شبکه وارد میشود، قوانینی برای بررسی گرهها یکی یکی وجود دارد تا مشخص شود آیا با تغییر مقدار آن گره، انرژی شبکه کاهش مییابد یا خیر. اگر مشخص شود که با تبدیل یک پیکسل سیاه به سفید، انرژی کاهش مییابد، آن پیکسل تغییر رنگ میدهد. این فرآیند ادامه پیدا میکند تا زمانی که هیچ بهبودی بیشتری قابل دستیابی نباشد. در این نقطه، شبکه معمولاً تصویر اصلی که روی آن آموزش دیده بود را بازتولید میکند.

این ممکن است چندان قابل توجه به نظر نرسد اگر تنها یک الگو ذخیره شود. شاید این سوال پیش بیاید که چرا تصویر را بهطور مستقیم ذخیره نمیکنیم و با تصویر دیگری که میخواهیم آزمایش کنیم مقایسه نمیکنیم؟ اما روش هاپفیلد خاص است زیرا چندین تصویر میتوانند همزمان ذخیره شوند و شبکه معمولاً قادر است آنها را از یکدیگر تشخیص دهد.

هاپفیلد جستجو در شبکه برای یافتن یک حالت ذخیرهشده را به حرکت یک توپ در منظرهای از قلهها و درهها، با اصطکاکی که حرکت را کند میکند، تشبیه کرد. اگر توپ در نقطه خاصی رها شود، به سمت نزدیکترین دره میغلتد و در آنجا متوقف میشود. به همین ترتیب، اگر به شبکه الگویی نزدیک به یکی از الگوهای ذخیرهشده داده شود، شبکه به حرکت خود ادامه میدهد تا در پایینترین نقطه یک دره در منظره انرژی قرار گیرد و به این ترتیب، نزدیکترین الگو را در حافظه خود پیدا کند.

شبکه هاپفیلد میتواند دادههایی را که شامل نویز است یا بهطور جزئی پاک شدهاند، بازسازی کند.

هاپفیلد و دیگران به توسعه جزئیات عملکرد شبکه هاپفیلد ادامه دادند، از جمله گرههایی که میتوانند هر مقداری را ذخیره کنند، نه فقط صفر یا یک. اگر گرهها را بهعنوان پیکسلهای یک تصویر تصور کنید، آنها میتوانند رنگهای مختلفی داشته باشند، نه فقط سیاه یا سفید. روشهای بهبود یافته امکان ذخیره تصاویر بیشتر و تفکیک آنها را حتی زمانی که بسیار مشابه باشند، فراهم کرده است. همچنین، امکان شناسایی یا بازسازی هرگونه اطلاعات دیگر، به شرطی که از تعداد زیادی نقاط داده تشکیل شده باشد، وجود دارد.

طبقهبندی با استفاده از فیزیک قرن نوزدهم

به خاطر سپردن یک تصویر یک موضوع است، اما تفسیر آنچه که به تصویر کشیده شده نیاز به کمی بیشتر دارد.

حتی کودکان خیلی کمسن میتوانند به حیوانات مختلف اشاره کنند و با اطمینان بگویند که آیا آن حیوان سگ، گربه یا سنجاب است. ممکن است گاهی اشتباه کنند، اما به سرعت یاد میگیرند که تقریباً همیشه درست تشخیص دهند. یک کودک بدون دیدن نمودارها یا توضیحات درباره مفاهیمی مانند گونه یا پستاندار، میتواند این را بیاموزد. پس از مواجهه با چند نمونه از هر نوع حیوان، دستهبندیهای مختلف در ذهن کودک شکل میگیرند. افراد با تجربه محیط اطراف خود یاد میگیرند که گربه را تشخیص دهند، یک کلمه را بفهمند، یا وارد اتاق شوند و متوجه شوند چیزی تغییر کرده است.

وقتی هاپفیلد مقاله خود را درباره حافظه تداعیگر منتشر کرد، جفری هینتون در دانشگاه کارنگی ملون در پیتسبورگ، ایالات متحده آمریکا کار میکرد. او پیش از این روانشناسی تجربی و هوش مصنوعی را در انگلستان و اسکاتلند مطالعه کرده بود و به این فکر میکرد که آیا ماشینها میتوانند الگوها را بهشیوهای مشابه انسان پردازش کنند و خودشان دستهبندیهایی برای مرتبسازی و تفسیر اطلاعات پیدا کنند. او همراه با همکارش ترنس سجنوفسکی، از شبکه هاپفیلد شروع کرد و با استفاده از ایدههایی از فیزیک آماری، آن را گسترش داد تا چیزی جدید بسازد.

فیزیک آماری سیستمهایی را توصیف میکند که از عناصر مشابه بسیاری، مانند مولکولهای گاز، تشکیل شدهاند. پیگیری تمام مولکولهای گاز به صورت جداگانه دشوار یا غیرممکن است، اما میتوان آنها را به صورت کلی بررسی کرد تا ویژگیهای اصلی گاز مانند فشار یا دما را تعیین کرد. روشهای مختلفی وجود دارد که مولکولهای گاز میتوانند در حجم خود با سرعتهای مختلف پخش شوند و همچنان به همان ویژگیهای کلی برسند.

حالتهایی که اجزای فردی میتوانند بهطور مشترک در آنها وجود داشته باشند، با استفاده از فیزیک آماری تحلیل میشوند و احتمال وقوع آنها محاسبه میشود. برخی از حالتها نسبت به دیگر حالتها محتملتر هستند؛ این به میزان انرژی موجود بستگی دارد که در معادلهای توسط فیزیکدان قرن نوزدهم، لودویگ بولتزمن، توصیف شده است. شبکه هینتون از آن معادله استفاده کرد و این روش در سال ۱۹۸۵ با نام برجسته ماشین بولتزمن منتشر شد.

تشخیص نمونههای جدید از همان نوع

ماشین بولتزمن معمولاً با دو نوع مختلف از گرهها کار میکند. اطلاعات به یک گروه وارد میشود که گرههای مرئی نام دارند. گروه دیگر، لایهای پنهان تشکیل میدهد. مقادیر و اتصالات گرههای پنهان نیز به انرژی کل شبکه کمک میکند.

ماشین با اعمال یک قاعده برای بهروزرسانی مقادیر گرهها یکی یکی اجرا میشود. در نهایت، ماشین وارد حالتی میشود که الگوی گرهها ممکن است تغییر کند، اما ویژگیهای کلی شبکه ثابت میمانند. هر الگوی ممکن دارای احتمالی خاص است که بر اساس انرژی شبکه طبق معادله بولتزمن تعیین میشود. وقتی ماشین متوقف میشود، الگوی جدیدی ایجاد کرده است و این باعث میشود ماشین بولتزمن بهعنوان یکی از نخستین مدلهای مولد شناخته شود.

ماشین بولتزمن میتواند یاد بگیرد – نه از طریق دستورالعملها، بلکه با ارائه مثالها. آموزش این ماشین با بهروزرسانی مقادیر اتصالات شبکه صورت میگیرد بهگونهای که الگوهای مثالی که در هنگام آموزش به گرههای مرئی داده شدهاند، بیشترین احتمال رخ دادن را در زمان اجرای ماشین داشته باشند. اگر یک الگو در طول آموزش چندین بار تکرار شود، احتمال وقوع آن الگو حتی بیشتر میشود. آموزش همچنین احتمال تولید الگوهای جدیدی را که شبیه به مثالهای ارائهشده در طول آموزش هستند، تحت تأثیر قرار میدهد.

یک ماشین بولتزمن آموزشدیده میتواند ویژگیهای آشنا را در اطلاعاتی که قبلاً ندیده است، شناسایی کند. تصور کنید با خواهر یا برادر دوستتان ملاقات کنید و فوراً متوجه شوید که آنها باید با هم نسبت داشته باشند. بهطور مشابه، ماشین بولتزمن میتواند یک نمونه کاملاً جدید را شناسایی کند اگر به دستهای تعلق داشته باشد که در دادههای آموزشی وجود داشته، و آن را از دادههایی که متفاوت هستند، متمایز کند.

در شکل اصلی خود، ماشین بولتزمن نسبتاً ناکارآمد است و زمان زیادی برای یافتن راهحلها نیاز دارد. زمانی که این ماشین به روشهای مختلف توسعه داده میشود، موضوع جالبتر میشود، که هینتون همچنان به بررسی آنها ادامه داده است. نسخههای بعدی ماشین بهبود یافتهاند؛ بهطوری که برخی از اتصالات بین واحدها حذف شدهاند. مشخص شده که این امر ممکن است کارایی ماشین را افزایش دهد.

در طول دهه ۱۹۹۰، بسیاری از محققان علاقه خود را به شبکههای عصبی مصنوعی از دست دادند، اما هینتون از افرادی بود که همچنان به کار در این حوزه ادامه داد. او همچنین به شروع موج جدیدی از نتایج هیجانانگیز کمک کرد. در سال ۲۰۰۶، او و همکارانش سایمون اوسیندرو، یی وی ته و روسلان سالاخوتدینوف روشی را برای پیشآموزش یک شبکه با استفاده از مجموعهای از ماشینهای بولتزمن در لایههای مختلف، یکی روی دیگری، توسعه دادند. این پیشآموزش به اتصالات شبکه یک نقطه شروع بهتر داد که آموزش شبکه را برای تشخیص عناصر موجود در تصاویر بهینهسازی کرد.

ماشین بولتزمن اغلب بهعنوان بخشی از یک شبکه بزرگتر استفاده میشود. بهعنوان مثال، میتوان از آن برای پیشنهاد فیلم یا سریالهای تلویزیونی بر اساس ترجیحات بیننده استفاده کرد.

یادگیری ماشین – امروز و فردا

به لطف کارهای جان هاپفیلد و جفری هینتون از دهه ۱۹۸۰ به بعد، آنها کمک کردند تا پایهگذار انقلاب یادگیری ماشین شوند که از حدود سال ۲۰۱۰ آغاز شد.

پیشرفتهایی که اکنون شاهد آن هستیم، با دسترسی به مقادیر عظیمی از دادهها که میتوان برای آموزش شبکهها استفاده کرد و افزایش چشمگیر قدرت محاسباتی ممکن شده است. شبکههای عصبی مصنوعی امروزی اغلب بسیار بزرگ هستند و از لایههای متعددی ساخته شدهاند. این شبکهها با نام شبکههای عصبی عمیق شناخته میشوند و روش آموزش آنها یادگیری عمیق نام دارد.

نگاهی سریع به مقاله هاپفیلد درباره حافظه انجمنی در سال ۱۹۸۲، تصویری از این پیشرفت را ارائه میدهد. او در آن مقاله از شبکهای با ۳۰ گره استفاده کرده بود. اگر تمام گرهها به یکدیگر متصل باشند، ۴۳۵ اتصال وجود دارد. گرهها مقادیر خود را دارند، اتصالات دارای قدرتهای مختلفی هستند و در مجموع، کمتر از ۵۰۰ پارامتر وجود داشت که باید پیگیری میشد. او همچنین شبکهای با ۱۰۰ گره را امتحان کرد، اما این شبکه با توجه به کامپیوتری که او در آن زمان استفاده میکرد، بیش از حد پیچیده بود. حالا میتوان این را با مدلهای زبانی بزرگ امروزی مقایسه کرد که به صورت شبکههایی ساخته میشوند که میتوانند بیش از یک تریلیون پارامتر (یک میلیون میلیون) داشته باشند.

امروزه بسیاری از محققان در حال توسعه کاربردهای یادگیری ماشین هستند. اینکه کدام یک از این کاربردها بیشترین موفقیت را خواهند داشت هنوز مشخص نیست، در حالی که بحثهای گستردهای نیز پیرامون مسائل اخلاقی مرتبط با توسعه و استفاده از این فناوری وجود دارد.

از آنجا که فیزیک ابزارهایی برای توسعه یادگیری ماشین ارائه کرده است، جالب است ببینیم چگونه فیزیک بهعنوان یک حوزه پژوهشی نیز از شبکههای عصبی مصنوعی بهرهمند شده است. یادگیری ماشین مدتهاست که در حوزههایی که شاید با جوایز نوبل فیزیک قبلی آشنا هستیم، استفاده میشود. این شامل استفاده از یادگیری ماشین برای تحلیل و پردازش مقادیر عظیم دادهها برای کشف ذره هیگز است. دیگر کاربردها شامل کاهش نویز در اندازهگیری امواج گرانشی از برخورد سیاهچالهها یا جستجوی سیارات فراخورشیدی است.

در سالهای اخیر، این فناوری همچنین برای محاسبه و پیشبینی ویژگیهای مولکولها و مواد به کار گرفته شده است – مانند محاسبه ساختار مولکولهای پروتئین که عملکرد آنها را تعیین میکند، یا بررسی اینکه کدام نسخههای جدید از یک ماده میتوانند بهترین ویژگیها را برای استفاده در سلولهای خورشیدی کارآمدتر داشته باشند.